テレビで連日話題が絶えない「ChatGPT」

実際にどれだけ凄いものなのか今回調べてみました。

ChatGPTとは

ChatGPTはオリジナルのテキスト文言を生み出すことができる画期的な人工知能ツールです。指定のフォーム内に、文言を入れることで詩や歌、エッセイ、短編小説、コードなどを書いてもらうこともできます。

ChatGPTはいつから…!?

ChatGPTが世間に知られたのは2022年11月。開発者は人工知能の研究開発に特化したOpenAIという企業です。

また、OpenAIの設立にはあのイーロン・マスク氏も参加していいるそうで、他にも有名な投資家らが何人も名を連ねているそうです。代表は、サム・アルトマンCEO。

ChatGPTの特徴

現在、ChatGPTは、誰もが無償で使える状態です。(2023年2月時点)

基本無料で利用することが可能なのですが、月額で約2,500円のサブスクリプションプラン 「ChatGPT Plus」も発表されています。

機能としては、無償版の際に、時々悩まされるアクセスできないという状態をケアしてくれる機能やピーク時でもアクセスしやすくなること、応答時間の短縮等の新機能などが使えるようになります。

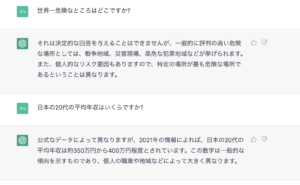

調べてみると本当に的確に答えてくれます…!!

公式サイトからの学習方法を以下にて、翻訳したものを記載しておきますので、

ぜひご参考にしていただければと思います。

Methods (EN)

We trained this model using Reinforcement Learning from Human Feedback (RLHF), using the same methods as InstructGPT, but with slight differences in the data collection setup. We trained an initial model using supervised fine-tuning: human AI trainers provided conversations in which they played both sides—the user and an AI assistant. We gave the trainers access to model-written suggestions to help them compose their responses. We mixed this new dialogue dataset with the InstructGPT dataset, which we transformed into a dialogue format.To create a reward model for reinforcement learning, we needed to collect comparison data, which consisted of two or more model responses ranked by quality. To collect this data, we took conversations that AI trainers had with the chatbot. We randomly selected a model-written message, sampled several alternative completions, and had AI trainers rank them. Using these reward models, we can fine-tune the model using Proximal Policy Optimization. We performed several iterations of this process.

学習方法 (JPN)

このモデルは,InstructGPTと同じ手法で人間のフィードバックからの強化学(RLHF)を用いて学習させたのだが,データ収集の設定に若干の差異があります。これは、人間のAIトレーナーがユーザーとAIアシスタントの両者を演じた会話を提供するものとなります。訓練生はモデルによって書かれた提案にアクセスすることで、応答を構成するのに役立てることができます。この新しい対話データセットをInstructGPTデータセットと混合し、対話形式に変換した。

強化学習のための報酬モデルを作成するためには、2つ以上のモデルの反応を品質でランク付けした比較データを収集する必要がありました。このデータを収集するために、AIトレーナーがチャットボットと交わした会話を取り込みました。モデルが書いたメッセージをランダムに選択し、いくつかの選択肢をサンプリングして、AIトレーナーに順位をつけてもらいました。この報酬モデルを使って、Proximal Policy Optimizationでモデルの微調整を行います。このプロセスを何度か繰り返しました。

引用 : https://openai.com/

要約すると、ChatGPT自体はもっともらしい回答を得られるが、正確性にはまだ欠ける部分があるようです。個人的な見解ではありますが、ChatGPTを使用する際は、参考程度に調べるという用途が適しているのかなと現状では思います。

ただこれからアップデートもかかり、精度を含めさらなる進化したサービスになるかと思うので、どちらにしてもとても期待値が高いものですね…!!